小语种情感分析研究|中科闻歌认知计算部

01

背景及挑战

随着互联网技术的快速发展和普及,大量来自不同国家使用不同语言的用户在Twitter、Facebook等社交媒体中针对新闻时事、政策法规、消费产品等话题发表的主观评论,很好地反映了用户个体的观点、情感、态度等重要信息。研究如何利用文本分析和挖掘技术对各语种文本中用户所表达的情感进行理解,对舆论监测、商业分析等领域具有重要意义。

情感分析是自然语言处理领域的重要任务,主要方法包括早期基于规则的无监督方法、基于文本表层情感特征的传统机器学习方法,以及近期基于深度学习的方法等。针对语言丰富的语种(例如中文、英文等),学术界和工业界都提出了大量情感分析方法和工具,然而面向小语种文本的情感分析任务目前仍然面临诸多挑战,主要包括以下两个方面:

大多数小语种形态丰富,不同语系的语种表达形式差异较大,并没有通用处理文本的方法;

相关研究和有标注的公开语料资源很少,难以支撑模型训练。

02

小语种情感分析方法调研

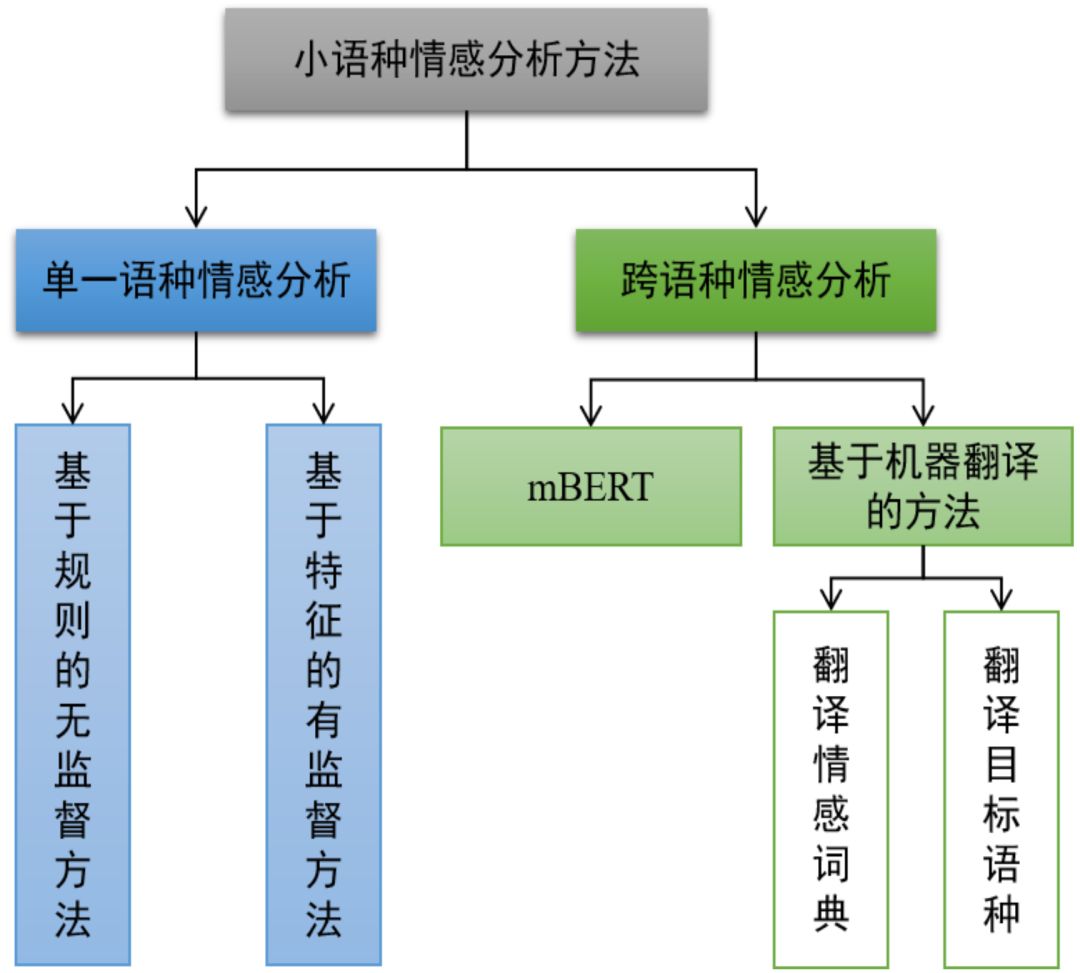

图1. 小语种情感分析方法分类

具体来说,单一语种情感分析方法是指在目标小语种数据上直接进行的情感分析,如构建该语种情感词典并采用基于规则的无监督方法[1];或是首先挖掘该语种自身文本特征,并应用有监督的分类方法[2,3]。相对而言,跨语种情感分析方法的主要思路是通过建立源语言(即中文、英文等具有丰富语言资源的语种)与目标语言(即待研究的语种)之间的映射,将源语言的情感知识迁移到目标语言上以辅助目标语言的情感分析任务,其中主要的情感知识迁移方法包括基于机器翻译的方法和基于BERT的方法等。基于机器翻译的方法[4,5,6]可以直接将目标语言文本直接翻译为源语言文本,并转化为源语言的情感分析任务;或者将已有的源语言的情感词典翻译为目标语种的情感词典,并采用基于规则的无监督情感分析方法。BERT模型[7]自从2018年发表以来,已经在多个关键的NLP任务中取得非常好的效果,如命名实体识别、文本分类、自动问答等等。相关研究[8]发现,采用维基百科中100多种语种的大量非对齐文本作为预训练语料,BERT在多语种任务中同样具有良好的表现(简称为mBERT,即Multilingual BERT)。

03

实验

3.1

数据集和方法选择

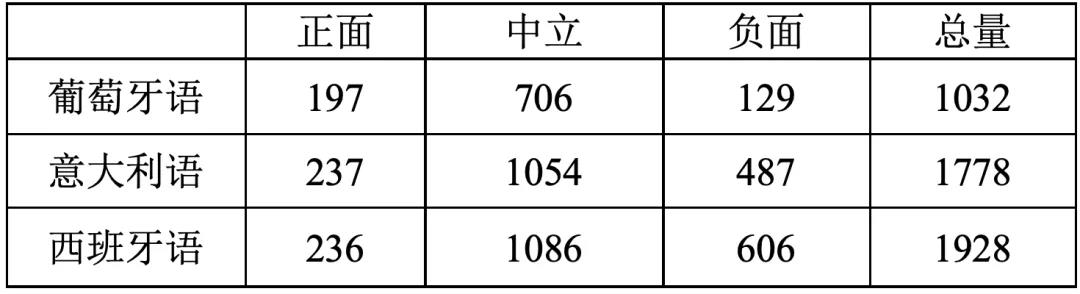

表1. 整体数据标签分布

3.2

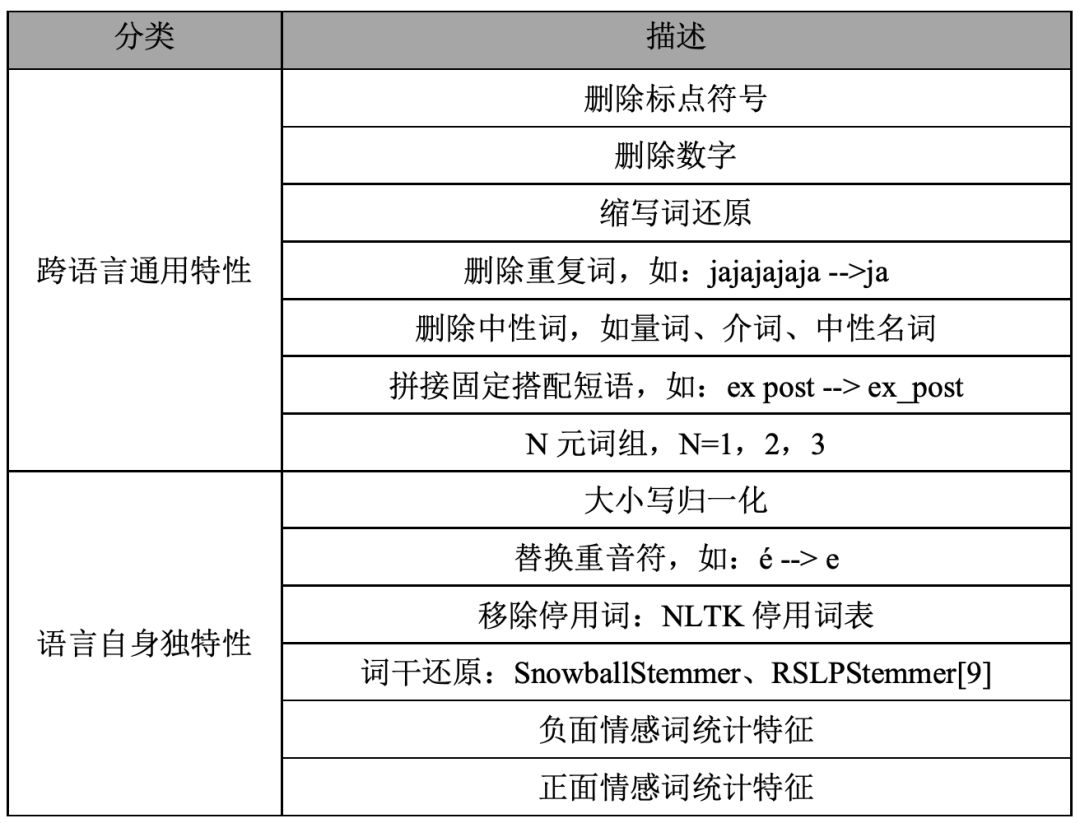

小语种文本处理方法及特征选择

表2. 小语种文本预处理和特征提取

3.3

实验结果及分析

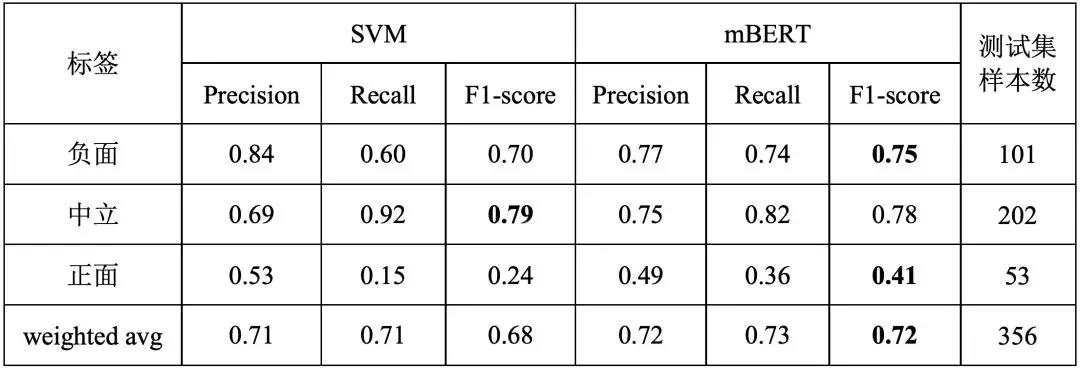

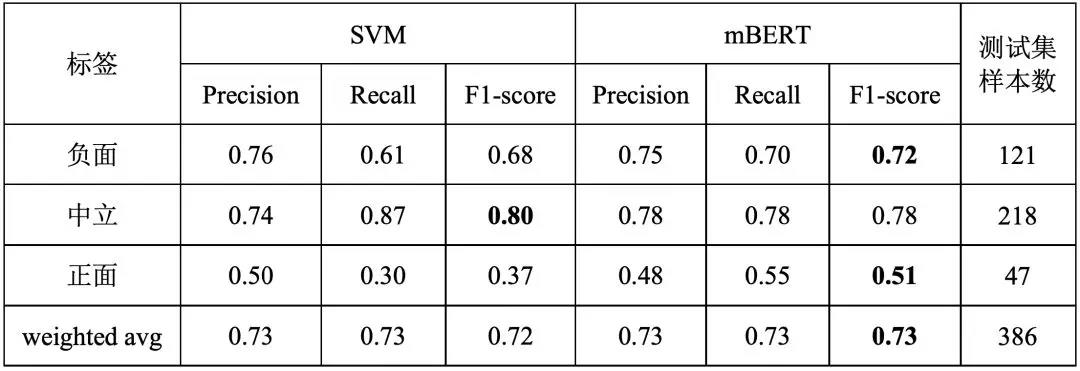

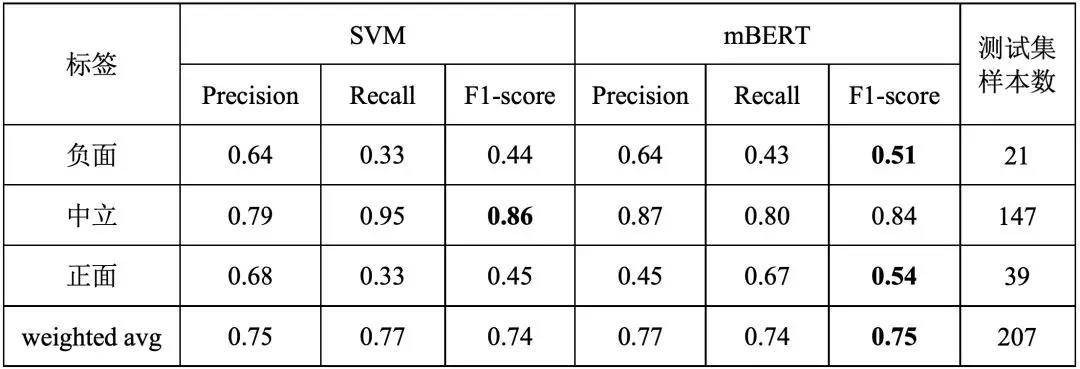

我们分别整理了在意大利语、西班牙语和葡萄牙语数据上基于SVM和mBERT模型的分类效果,评估标准为精确率、召回率和F1分值,如表3、表4和表5所示。从实验结果中可以发现,mBERT模型预测结果在三个小语种数据集上整体(F1值)优于SVM模型,但SVM模型在精确率上(尤其是正、负面样本)优于mBERT模型。可能原因为手工抽取的文本特征一般针对性较强,但是在整体泛化能力上稍弱。相对于中立数据,正面和负面数据量较少,但mBERT模型依然有效提升了“正面”和“负面”情感标签判别的F1值,说明mBERT在不平衡数据集下仍具有良好表现。

另外,我们还发现特征选择对小语种情感分析同样重要,比如在西班牙语数据上,利用情感特征对模型整体判别效果没有明显提升,对葡萄牙语移除停用词同样无明显作用。

表3. 意大利语情感分析结果

表4. 西班牙语情感分析结果

表5. 葡萄牙语情感分析结果

04

总结

本文首先对小语种的情感分析方法进行了调研,并分别对比了基于手工文本特征的传统机器学习模型(SVM)和近年来NLP领域最受关注的mBERT模型在意大利语、西班牙语、葡萄牙语语种情感分析中的效果。另外,我们还详细介绍了如何针对以上小语种进行预处理和文本特征抽取。实验表明,mBERT整体上比传统机器学习模型效果更好,但是后者在正面和负面样本的精确率上性能更佳。(作者:王宇琪、王婧宜、孔庆超)

参考文献

[1] Hutto, Clayton J., and Eric Gilbert. "Vader: A parsimonious rule-based model for sentiment analysis of social media text." Eighth international AAAI conference on weblogs and social media. 2014.

[2] Abdul-Mageed, Muhammad, Mona Diab, and Sandra Kübler. "SAMAR: Subjectivity and sentiment analysis for Arabic social media." Computer Speech & Language 28.1 (2014): 20-37.

[3] Tellez, Eric S., et al. "A simple approach to multilingual polarity classification in Twitter." Pattern Recognition Letters 94 (2017): 68-74.

[4] Can, Ethem F., Aysu Ezen-Can, and Fazli Can. "Multilingual Sentiment Analysis: An RNN-Based Framework for Limited Data." arXiv preprint arXiv:1806.04511 (2018).

[5] Denecke, Kerstin. "Using sentiwordnet for multilingual sentiment analysis." 2008 IEEE 24th International Conference on Data Engineering Workshop. IEEE, 2008.

[6] Feng, Yanlin, and Xiaojun Wan. "Learning Bilingual Sentiment-Specific Word Embeddings without Cross-lingual Supervision." Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers). 2019.

[7] Devlin, Jacob, et al. "Bert: Pre-training of deep bidirectional transformers for language understanding." arXiv preprint arXiv:1810.04805 (2018).

[8] Wu, Shijie, and Mark Dredze. "Beto, bentz, becas: The surprising cross-lingual effectiveness of bert." arXiv preprint arXiv:1904.09077 (2019).

[9] Orengo, Viviane Moreira, and Christian R. Huyck. "A Stemming Algorithmm for the Portuguese Language." spire. Vol. 8. 2001.

业务合作

业务合作 在线留言

在线留言 在线咨询

在线咨询